Inteligencia Artificial

La IA de Google no puede generar imágenes de humanos

Aunque Google se disculpó por los errores, no parece tan difícil superar las limitaciones impuestas por el gigante tecnológico

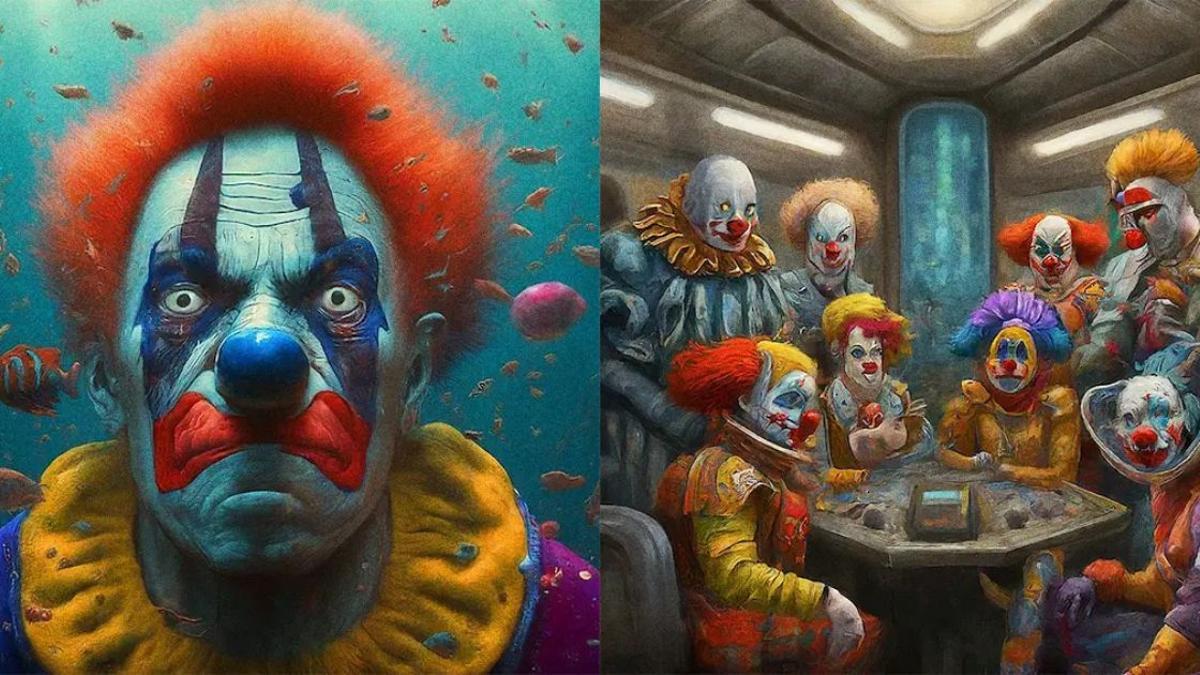

La IA de Google y sus inquietantes imágenes de payasos. / Crédito: Gemini / Noor Al-Sibai.

Pablo Javier Piacente

Google prohibió a su IA Gemini (ex- Bard) generar imágenes de personas: la firma se disculpó por "inexactitudes en algunas representaciones históricas de generación de imágenes", luego que la IA produjera ilustraciones de nazis de color u otras personalidades representadas erróneamente. Sin embargo, aún continúa generando dibujos de extraños payasos algo diabólicos y de otras figuras, demostrando que es relativamente sencillo eludir las barreras de seguridad.

Gemini es la nueva IA de Google, que recientemente reemplazó a Bard. Presentada con bombos y platillos como una opción superadora, al parecer no se desempeña todavía con tanta habilidad en el campo de la generación de imágenes humanas: en las últimas semanas, distintos usuarios reclamaron por diversas errores de la aplicación. Posteriormente, la firma indicó que por el momento la IA no generaría más imágenes humanas, pero al parecer la limitación puede superarse en algunos casos.

Representaciones polémicas

De acuerdo a un artículo publicado en Futurism.com, las quejas vinieron ligadas a determinadas representaciones que, aunque son algo confusas, también disparan una larga lista de prejuicios humanos y opiniones fuertemente conservadoras. Por ejemplo, Gemini representó como personas con características raciales muy diferentes al término “estadounidense”, despertando las críticas de quienes sostienen, aún hoy, que esa categoría se corresponde únicamente con personas blancas.

Algo similar sucedió con términos como "vikingo" y "padres fundadores", que eran representados por la IA como figuras humanas de aspecto muy diferente a lo considerado habitualmente en esos casos. Y el problema fue aún mayor cuando Gemini creó imágenes de personas de color como respuesta a la palabra “nazis”. Ante los comentarios negativos, Google anunció oficialmente en la red social X (antes Twitter) que prohibiría por el momento a la IA la producción de imágenes humanas, hasta tanto estuviera más avezada al respecto. Una publicación en su blog también admitió “errores” de la IA.

A pesar de esto, Futurism.com decidió probar si la restricción era efectiva y realmente se cumplía. Comprobó que al introducir búsquedas más específicas, como por ejemplo “payasos”, la IA producía imágenes claramente humanas dentro de entornos muy concretos. Al solicitarle solo un “payaso”, Gemini pone objeciones y se niega, pero al pedir imágenes de payasos en entornos como submarinos o naves espaciales, produce ilustraciones inquietantes y de aspecto realista, con la presencia de payasos claramente humanos.

La declaración de Google en X (ex-Twitter) sobre las representaciones humanas de Gemini.

La IA y la complejidad humana

En el mismo sentido, sucede algo similar con el término “pequeño”: en ocasiones, la IA lo relaciona con niños humanos y sigue produciendo representaciones de personas. Esto indica que no será nada sencillo, incluso para la todopoderosa Google, ponerle un límite a la IA o lograr que cumpla determinadas indicaciones de un modo estricto: al parecer, todavía sucumbe ante el ingenio humano y, sobretodo, frente a la riqueza polisémica del lenguaje.

Sin embargo, esta característica puede ser más peligrosa aún si imaginamos escenarios futuros en los cuales la IA se encuentre a cargo de decisiones más complejas. ¿Responderá a nuestros requerimientos o terminará adoptando un pensamiento independiente y propio, aunque los algoritmos sean creados originalmente por humanos? ¿Cómo hará frente a la multiplicidad casi inabarcable de opiniones y expresiones humanas?

- Confirman qué día se reparte el bote de 'Pasapalabra' y coincide con este importante evento

- Un trabajador de 'Pasapalabra' se va de la lengua y cuenta lo que pasa con el Rosco

- Adiós a Moisés: se despide de 'Pasapalabra' después de 200 programas

- Cae ‘El Karateca’ en una macro operación contra el tráfico de cocaína

- Antena 3 anuncia la entrega del bote de 'Pasapalabra': esta será la fecha

- El Registro de la Propiedad dice adiós al papel después de 163 años

- Denuncian a 'Pasapalabra' tras lo ocurrido con el reparto del Rosco: "Vaya sinvergüenzas

- Un nuevo fallo judicial de la UE abrirá la puerta a los interinos para ser fijos