Violencia sexual

Oportunidad perdida para combatir el porno 'deepfake' desde el Código Penal

El Parlamento ha rechazado criminalizar estas prácticas que afectan de forma mayoritaria a mujeres

Oportunidad perdida para combatir el porno 'deepfake' desde el Código Penal.

Violeta Molina Gallardo

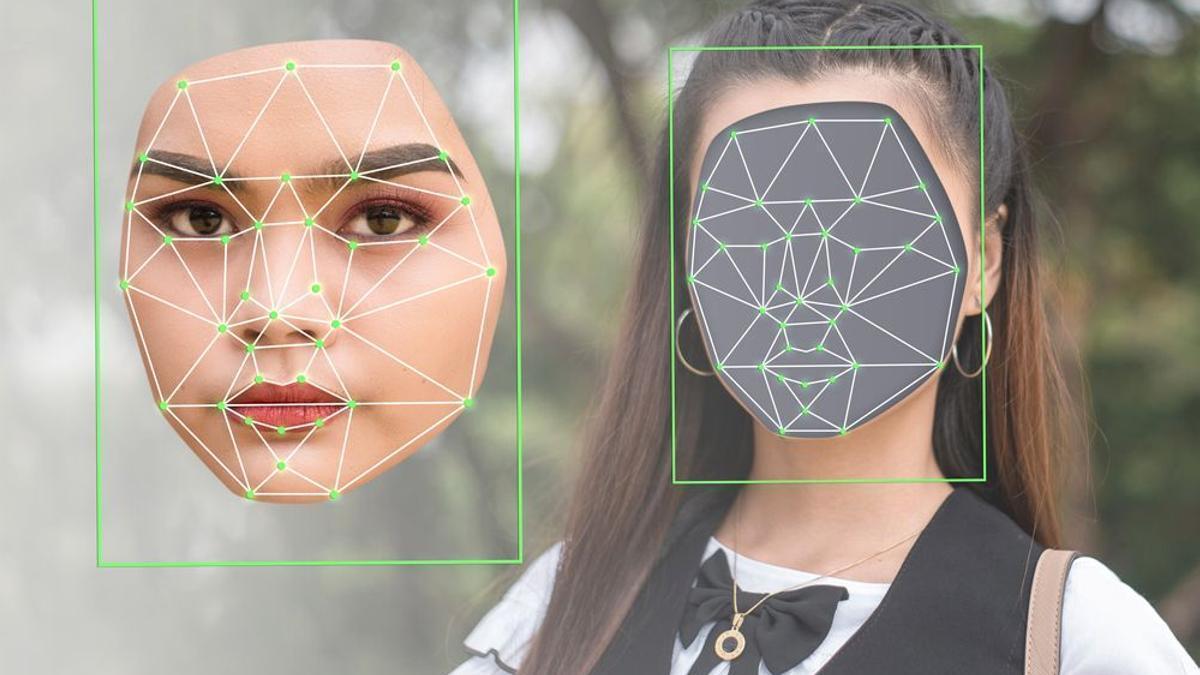

El impacto de la pornografía, la inteligencia artificial y la violencia contra las mujeres suponen grandes desafíos. La emergencia del porno deepfake, contenidos generados por IA a partir del uso no consentido de imágenes de personas reales, aúna las tres cuestiones y preocupa a juristas y legisladores. España tenía una oportunidad de tipificar esta realidad en el Código Penal, pero el Parlamento ha decidido esperar.

Cada vez se conocen más casos de deepfakes pornográficos: vídeos porno realistas en los que se ha modificado el rostro de las actrices para introducir la cara de otras mujeres, que en ningún momento han dado su consentimiento para ello. Son falsos, pero su apariencia es hiperrealista.

Un desafío para la justicia

La Asociación de Mujeres Juezas de España ha alzado la voz para alertar de esta "dura realidad", que constituye "una forma de ejercer violencia contra las mujeres".

"Desgraciadamente, son muchas mujeres (anónimas y conocidas) las que han denunciado que su rostro se ha utilizado sin su consentimiento para crear un deepfake y, a partir de él, una secuencia pornográfica", incide AMJE, que cita un estudio de Senty AI en el que se asegura que entre el 90 y el 95 % de los vídeos deepfake son pornografía no consentida.

Para esta asociación de juristas, se trata de un "desafío" que la justicia no puede ignorar: "Queda aún un gran camino en la definición e identificación de los delitos digitales como tales, por lo que muchas veces la denuncia se trata como un caso de injurias o como delito contra la integridad moral", afirman las juezas.

Propuesta para el Código Penal

La tecnología (su uso y su abuso) siempre va por delante de la legislación. Pero la preocupación por la emergencia de estos vídeos falsos y las graves consecuencias para las personas afectadas por su creación y divulgación ya han escalado al Congreso y al Senado.

El Parlamento tenía la oportunidad de incluir en el Código Penal la criminalización específica de estos deepfakes pornográficos, aprovechando la reforma de la ley del 'sólo sí es sí', pero la mayoría conformada por PP y PSOE lo ha impedido. El argumento esgrimido fue que no eran ni el momento ni la forma de legislar sobre esta materia.

Fue JxCAT quien propuso la medida dentro de un paquete de enmiendas para combatir las consecuencias perjudiciales de la pornografía violenta.

La diputada de esta formación Pilar Calvo subraya, en declaraciones a EL PERIÓDICO DE ESPAÑA, del grupo Prensa Ibérica, que es urgente legislar contra el uso indebido del deepfake: "Estamos ante una situación en la que la tecnología está haciéndonos ir detrás legislativamente a la hora de cubrir los agujeros de protección que tiene el actual Código Penal. Es urgente porque cualquier atentado contra el honor debe ser perseguido y castigado. (...) No está contemplado todavía como tipo delictivo, pero debiera serlo", señala.

El partido independentista catalán denuncia que estos contenidos falsos generados por inteligencia artificial tienen tanta verosimilitud que pueden engañar tanto a las personas que lo ven o escuchan como a los propios algoritmos.

"Cuando la imagen de una persona se utiliza para crear contenidos pornográficos u otras acciones que puedan ser muy lesivas para la persona que se convierte en protagonista de manera involuntaria y virtual, se menoscaba gravemente su honor o su intimidad por lo que dicha situación debe ser reprobada penalmente", defendía JxCAT al justificar su enmienda, y también ponía el foco en que la creación de esos vídeos tienen "la intención premeditada de causar daño a la persona cuya imagen se reproduce".

Por ello, este partido planteaba castigar con penas de prisión de seis meses a dos años a quien utilizara "imágenes de gran verosimilitud (deepfake) elaboradas con inteligencia artificial para reproducir la imagen de una persona o imágenes reales obtenidas sin su consentimiento con el objetivo de crear contenidos audiovisuales que puedan ser difundidos públicamente por cualquier medio, cuando la divulgación menoscabe gravemente el honor o la intimidad de esa persona". Y establecía multas de uno a tres meses a quien redifundiera esos contenidos a terceras personas.

Populares y socialistas declinaron apoyarla, así que la propuesta cayó en saco roto. "No podemos dejar pasar estas oportunidades de proteger del uso problemático de la pornografía. (...) Es un problema social que hay que corregir y solucionar en breve. Entendíamos que la revisión de la ley del sí es sí era una gran oportunidad, pero se ha perdido. Habrá que seguir luchando por este tema porque la sociedad sí lo tiene claro", enfatiza la diputada de JxCAT.

Cómo castigar el porno deepfake

Y ante ese escenario, ¿qué se puede hacer si una persona se ve afectada por un deepfake empleado para crear material pornográfico?

El abogado especializado en delitos informáticos Carlos Sánchez Almeida indica, en conversación con EL PERIÓDICO DE ESPAÑA, que sería correcto criminalizarlos de forma específica. Sin embargo, descarta que se trata de un delito contra la intimidad (porque el cuerpo exhibido no es de la persona afectada, lo que se usa indebidamente es la cara), sino contra la integridad moral.

En la actualidad, y a pesar de que no se haya legislado para dar una respuesta específica a esta realidad, se podría castigar con la legislación vigente. En concreto, sostiene el abogado, se podría aplicarse tanto el artículo del Código Penal sobre ciberacoso como el que tipifica el trato degradante contra la integridad moral.

La ley castiga el acoso que se produce "mediante el uso indebido" de los datos personales de una persona y también a quien utilice sin consentimiento "la imagen de una persona para realizar anuncios o abrir perfiles falsos en redes sociales, páginas de contacto o cualquier medio de difusión pública, ocasionándole a la misma situación de acoso, hostigamiento o humillación" .

Además, continúa Sánchez Almeida, contra el uso criminal del deepfake se puede aplicar el artículo que castiga con penas de seis meses a dos años quien inflija a otra persona un trato degradante, menoscabando gravemente su integridad moral.

El abogado precisa que se podrían aplicar un artículo o el otro, o incluso ambos a la vez, a la hora de juzgar estos hechos: "Acoso o integridad moral o los dos juntos", apunta.

Así, con la legislación actual, si una persona española fuera víctima de un deepfake para generar contenido pornográfico y lo denunciara, se abriría un procedimiento judicial por esos delitos.

Ahora bien, Sánchez Almeida añade que cabría incluir una tipificación específica, en el caso de que se quisiera recoger mejor el delito o incrementar la pena en un grado.

Además de recurrir a la justicia, las personas afectadas por estas prácticas, en su inmensa mayoría mujeres, pueden pedir la ayuda de la Agencia Española de Protección de Datos (AEPD). En concreto, de su canal prioritario para "comunicar la difusión ilícita de contenido sensible, un sistema que tiene como objetivo dar una respuesta rápida en situaciones excepcionalmente delicadas, como aquellas que incluyen la difusión de contenido sexual o violento".

Fuentes de la AEPD indican a este periódico que en estos supuestos de contenido pornográfico, aunque hayan sido elaborados con inteligencia artificial, se utilizan datos personales de la persona agraviada (la imagen de su cara) que permiten identificarla, con lo que el canal prioritario puede actuar para lograr la retirada de esos vídeos.

El 016 atiende a las víctimas de todas las violencias contra las mujeres. Es un teléfono gratuito y confidencial que presta servicio en 53 idiomas y no deja rastro en la factura. También se ofrece información a través del correo electrónico 016-online@igualdad.gob.es y asesoramiento y atención psicosocial mediante el número de Whatsapp 600 000 016. Además, los menores pueden dirigirse al teléfono de ANAR 900202010.

Las víctimas de maltrato sordas, con discapacidad auditiva, ciegas o sordociegas pueden llamar al 016 con 900 116 016, SVisual, ALBA, Telesor, ATENPRO y la app PorMí. Todos los recursos contra la violencia de género.

- Página no encontrada - La Opinión de Murcia

- Proponen dividir la Región de Murcia en estas nuevas 8 provincias y toda España aplaude la idea

- Irene Rosales toma una decisión sin marcha atrás sobre la relación con Kiko Rivera

- Página no encontrada - La Opinión de Murcia

- Mueren los conductores de dos camiones tras chocar de frente en Fortuna

- Un pueblo de Murcia se convierte en centro del turismo mundial por este curioso fenómeno

- Malos tiempos para los interinos

- Ocho meses del Trasvase a la basura por los limones sin recoger de la Región de Murcia